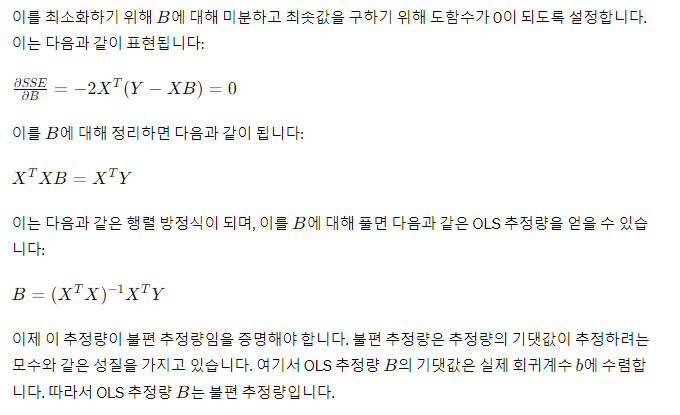

1. 다중회귀모델 y = bX + e 에서 회귀계수 b의 정의를 행렬연산으로 증명하라. 그리고 b가 불편추정량임을 증명하라. → 완전한 증명문제, b 정의하는 식 유도

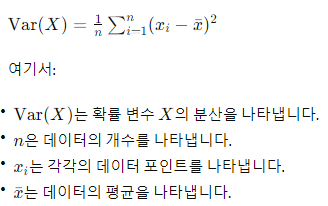

2. 표본분산에 관한 잘못된 공식을 주어주고 이 공식이 왜 틀렸는지(불편추정량이 아닌지) 밝히고 맞게 수정하라. → 표본분산은 n으로 나누는게 아니라 n-1로 나눠야 하는지를 밝히라는 문제

불편 추정량

추정된 모수의 기대값이 모집단의 실제 모수와 같은 성질을 갖는 추정량입니다. 다시 말해, 불편 추정량은 표본으로부터 계산된 추정치가 편향되지 않는 추정량입니다. 이는 모집단의 모수를 추정할 때, 표본을 사용하여 그 추정치가 얼마나 정확한지를 나타냅니다.

자유도

통계적 추정이나 검정에서 사용되는 매개변수 중 하나입니다. 주어진 문제의 자유도는 통계적 추정이나 검정을 할 때 그에 대한 제약의 정도를 의미합니다. 특히, 자유도는 표본의 크기나 추정하는 모수의 개수와 관련이 있습니다.

표본분산의 경우, 수정된 공식에서 로 나누는 이유는 이 자유도 때문입니다. 자유도는 주어진 데이터 집합에서 계산된 추정치들이 얼마나 자유롭게 움직일 수 있는지를 결정합니다. 표본분산을 계산할 때, 우리는 표본의 평균을 이미 알고 있기 때문에 이것이 자유도에서 차감됩니다. 따라서 자유도는 표본 크기에서 1을 뺀 값입니다. 이렇게 함으로써 우리는 표본분산이 모집단의 분산을 과소평가하지 않도록 보정할 수 있습니다.

표본 분산은 모 분산보다 작은 경향이 있습니다. 모 분산보다 작아지려는 경향을 가진 표본 분산을 보존해줘야 합니다. n으로 나눈 표본 분산보다 n-1로 나눈 표본 분산 값이 더 클 것입니다. 이런 식으로 표본 분산의 작아지려는 경향을 자유도로 보존할 수 있습니다.

3. 한 학생의 두 과목 시험점수와 각 과목의 평균, 표준편차를 주고 어느 과목을 상대적으로 더 잘했는지 보여라. → 표준점수 Z 계산

한 학생의 과목 A, B의 시험 점수가 주어졌을 때, 각 과목의 표준점수(Z-score)는 다음과 같이 계산됩니다:

Z = (X−μ) / σ

- 는 개별 학생의 시험 점수,

- 는 해당 과목의 평균,

- 는 해당 과목의 표준편차입니다.

따라서 더 높은 표준점수를 가진 과목이 상대적으로 더 잘한 과목입니다.

[약술형 문제]

4. 상관행렬 주어주고 어느 변수가 회귀식을 선형으로 잘 나타내주는가 그리고 서로 공선문제를 가장 많이 발생시키는 변수쌍은 무엇인가

가 1에 가까울수록 변수들 간에 강한 양의 선형 관계가 있음을 의미하고, -1에 가까울수록 강한 음의 선형 관계가 있음을 의미합니다. 반면에 0에 가까울수록 변수 간의 선형 관계가 없거나 약한 선형 관계가 있음을 의미합니다.

공선성(다중공선성)은 회귀 분석에서 중요한 문제 중 하나입니다. 공선성은 독립 변수들 간에 강한 선형 상관 관계가 있는 경우 발생합니다. 이러한 상황에서는 회귀 분석 결과의 해석이 어려워지거나 왜곡될 수 있습니다.

다음은 공선성을 발견하고 해결하는 몇 가지 방법입니다:

- 상관 행렬 확인: 독립 변수들 간의 상관 행렬을 확인하여 상관 관계를 시각화합니다. 상관 행렬은 변수들 간의 선형 관계를 파악하는 데 유용합니다. 공선성이 높은 변수 쌍은 상관 행렬에서 높은 상관 계수를 보일 것입니다.

- VIF(분산팽창계수) 계산: VIF는 다중공선성을 측정하는 데 사용되는 통계적 지표입니다. 각 독립 변수의 VIF를 계산하여 다른 독립 변수들과의 관련성을 확인할 수 있습니다. VIF 값이 일정 수준(예: 10)을 초과하는 변수는 공선성이 발생할 가능성이 있습니다.

- 회귀 계수의 표준 오차 확인: 다중공선성이 높은 변수들은 회귀 계수의 표준 오차가 증가합니다. 이를 통해 회귀 계수의 정확성이 저하되었음을 알 수 있습니다.

- 변수 선택 기법: 변수 선택 기법을 사용하여 다중공선성이 높은 변수를 제거하거나 조정합니다. 변수 선택 방법에는 후진 제거법(backward elimination), 전진 선택법(forward selection), 단계적 선택법(stepwise selection) 등이 있습니다.

- PCA(주성분 분석): PCA는 변수들 간의 선형 종속성을 감지하고 변수들을 새로운 축으로 변환하여 다중공선성을 해결하는 데 사용될 수 있습니다.

5. 통계학 표본추출에서 무작위(random)의 의미는 무엇인가

통계학에서 "무작위(random)"란 모집단에서 표본을 추출할 때, 각 구성원이 선택될 확률이 동일하고, 각 선택이 다른 선택과 독립적으로 이루어진다는 의미를 가집니다.

즉, 무작위 표본 추출은 모집단의 각 구성원이 선택될 확률이 똑같고, 선택된 구성원의 정보가 이전이나 후속 선택에 영향을 미치지 않는 것을 보장합니다. 이것은 추출 방법이 완전히 무작위로 이루어진다는 것을 의미합니다.

예를 들어, 무작위 표본 추출은 다음과 같은 방법을 사용하여 이루어질 수 있습니다:

- 단순 무작위 표본 추출(Simple Random Sampling): 모집단에서 각 구성원이 동일한 확률로 선택되는 방법입니다. 예를 들어, 번호를 부여하고 무작위로 번호를 선택하여 표본을 추출할 수 있습니다.

- 계통적 무작위 표본 추출(Systematic Random Sampling): 모집단에서 일정한 간격으로 구성원을 선택하는 방법입니다. 예를 들어, 모집단을 선형적으로 나열하고 일정한 간격으로 구성원을 선택하여 표본을 추출할 수 있습니다.

- 군집 무작위 표본 추출(Cluster Random Sampling): 모집단을 여러 개의 군집으로 나눈 후, 몇 개의 군집을 무작위로 선택하여 각 군집에서 구성원을 추출하는 방법입니다.

이러한 방법을 통해 무작위 표본 추출은 표본이 모집단을 대표하고 편향되지 않도록 하는 데 중요한 역할을 합니다. 이는 통계적 추정과 가설 검정 등의 통계적 분석을 신뢰할 수 있도록 합니다.

6. 회귀분석 모델 생성한 결과 보여주고 회귀식의 적합도를 검정하기 위한 가설은 무엇이고 무슨 지표로 검증하는가

- 가설 검정:

- 회귀분석에서 가장 일반적인 가설은 회귀 계수에 대한 가설입니다.

- 귀무가설 Null Hypothesis() : 모든 회귀 계수는 0이다. 즉, 독립 변수들은 종속 변수에 영향을 미치지 않는다.

- 대립가설 Alternative Hypothesis() : 적어도 하나의 회귀 계수는 0이 아니다. 즉, 적어도 하나의 독립 변수는 종속 변수에 영향을 미친다.

- 가설 검정을 위한 통계적 지표:

- 일반적으로 F-통계량 또는 t-통계량을 사용하여 가설을 검정합니다.

- F-통계량은 전체 모델의 설명력을 나타내며, 회귀식이 통계적으로 유의한지를 판단합니다.

- t-통계량은 각 회귀 계수의 통계적 유의성을 검정합니다.

- 적합도 지표:

- 회귀분석 모델의 적합도를 평가하기 위해 여러 지표를 사용할 수 있습니다.

- 대표적으로 결정 계수(R-squared), 수정된 결정 계수(Adjusted R-squared), 잔차 표준 오차 등이 있습니다.

- 결정 계수는 종속 변수의 변동량 중 모델이 설명하는 비율을 나타냅니다. 1에 가까울수록 모델이 데이터를 잘 설명한다는 것을 의미합니다.

- 수정된 결정 계수는 회귀 모델에 추가된 독립 변수의 수를 고려하여 결정 계수를 보정한 값입니다.

4. 해석 방법:

- F-통계량에 대한 해석은 주로 p-value를 통해 이루어집니다. p-value는 귀무가설이 참일 때, 현재의 표본 데이터나 더 극단적인 결과가 관찰될 확률을 나타냅니다.

- 일반적으로 유의수준(alpha)은 0.05로 설정되며, 만약 p-value가 이보다 작으면 귀무가설을 기각하고 모델이 유의한 적합도를 가진다고 결론짓습니다.

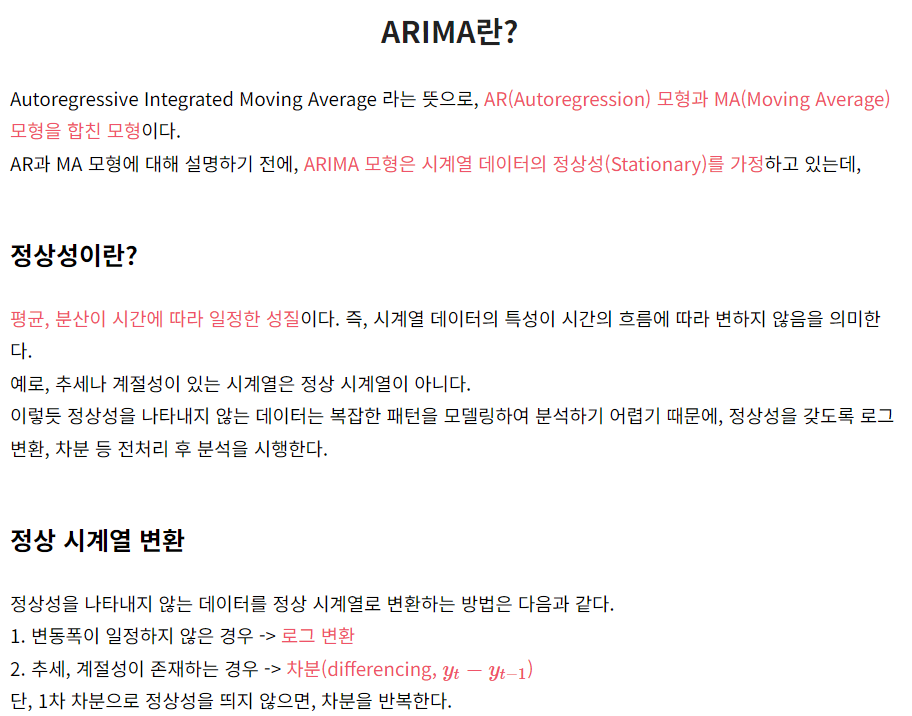

- ARIMA (Autoregressive Integrated Moving Average):

- ARIMA는 시계열 데이터의 패턴을 모델링하고 예측하는 데 사용되는 통계적 방법입니다.

- ARIMA 모델은 자기회귀(AR, Autoregressive), 차분(I, Integrated), 이동평균(MA, Moving Average) 세 가지 요소를 조합한 모델입니다.

- ARIMA 모델을 사용하여 시계열 데이터의 추세, 계절성 및 예측 가능한 패턴을 분석하고 예측할 수 있습니다.

- ACF 그래프 (Autocorrelation Function Plot):

- ACF 그래프는 시계열 데이터의 자기상관을 시각화하는 도구입니다.

- 자기상관은 시계열 데이터 내의 관측치가 이전 관측치와 얼마나 관련이 있는지를 나타냅니다.

- ACF 그래프를 통해 시계열 데이터의 자기상관 구조를 확인하고, ARIMA 모델의 적절한 차수를 결정하는 데 사용됩니다.

- ACF(Autocorrelation Function)와 유사하게 는 시계열 데이터의 자기상관을 시각화하고 분석하는 데 사용됩니다.

- PACF(Partial Autocorrelation Function)

- ACF는 각 시차(lag)에서의 자기상관을 나타내는 반면, PACF는 다른 시차의 영향을 제거한 후 해당 시차와의 자기상관을 나타냅니다. 이러한 특성으로 PACF는 시계열 데이터에서 유용한 패턴을 파악하고 모델링하는 데 도움이 됩니다. PACF를 사용하면 ARIMA 모델을 포함한 시계열 모델의 적합성을 평가하고, 적절한 모델을 식별하는 데 도움이 됩니다. 일반적으로 PACF 그래프를 통해 시계열 데이터의 자기회귀 구조를 시각화하고, PACF 그래프의 규칙을 기반으로 ARIMA 모델의 적절한 차수를 결정할 수 있습니다.

- PACF는 보통 ACF의 잔차에 대한 회귀모델에서의 회귀계수를 나타냅니다. 예를 들어, 3번째 시차의 PACF는 1번째, 2번째 시차의 영향을 제거한 후 3번째 시차와의 자기상관을 나타냅니다.

- Ljung-Box 검정 (Ljung-Box Test):

- Ljung-Box 검정은 시계열 데이터가 자기상관을 가지고 있는지를 검정하는 통계적 방법입니다.

- Ljung-Box 검정은 시계열 데이터의 일련의 관측치가 서로 독립적인지를 확인합니다.

- 시계열 데이터가 자기상관을 가지고 있다면, Ljung-Box 검정은 귀무가설을 기각하고 자기상관이 존재한다는 것을 나타냅니다.

- 누적분포함수 (CDF):

- 누적분포함수는 확률 변수가 특정 값보다 작거나 같은 값을 취할 확률을 나타내는 함수입니다.

- 주어진 확률 변수 에 대한 CDF는 일반적으로 로 표기되며, 다음과 같이 정의됩니다:

- 이는 확률 변수가 보다 작거나 같은 값을 가질 확률을 나타냅니다.

- 평균 (Mean):

- 확률 분포의 평균은 데이터 집합의 중심을 나타내는 지표로서, 주어진 확률 분포의 중심 경향성을 파악하는 데 사용됩니다.

- 이산 확률 변수의 경우, 평균은 각 값에 해당하는 확률의 가중 평균으로 계산됩니다.

- 연속 확률 변수의 경우, 평균은 확률 밀도 함수를 가중치로 사용하여 적분된 값으로 계산됩니다.

- 표준편차(Standard Deviation)는 데이터가 평균으로부터 얼마나 퍼져 있는지를 나타내는 측도

- 분산 (Variance):

- 분산은 데이터의 퍼짐 정도를 나타내는 지표로서, 평균으로부터의 편차를 제곱한 값들의 평균입니다.

- 이산 확률 변수의 분산은 각 값에서 평균을 뺀 후 제곱하여 확률로 가중치를 적용한 값의 평균입니다.

- 분산은 확률 분포의 산포도를 나타내며, 값이 클수록 데이터가 평균 주변에 퍼져있음을 나타냅니다.

변수 선택(Variable Selection)은 통계적 모델링이나 머신 러닝에서 중요한 단계 중 하나입니다. 이 단계에서는 모델에 포함될 독립 변수(또는 특성)를 선택하는 과정을 의미합니다. 변수 선택은 모델의 복잡성을 줄이고, 예측력을 향상시키며, 모델의 해석을 용이하게 만들어줄 수 있습니다.

변수 선택은 여러가지 방법으로 수행될 수 있습니다. 몇 가지 주요한 방법은 다음과 같습니다:

- 전진 선택(Forward Selection):

- 빈 모델부터 시작하여 각 단계에서 변수를 추가하는 방식입니다.

- 변수를 추가할 때마다 모델의 성능을 평가하고 선택 기준에 따라 변수를 추가합니다.

- 최적의 모델이 얻어질 때까지 반복합니다.

- 후진 제거(Backward Elimination):

- 모든 변수를 포함한 전체 모델부터 시작하여 각 단계에서 변수를 제거하는 방식입니다.

- 변수를 제거할 때마다 모델의 성능을 평가하고 선택 기준에 따라 변수를 제거합니다.

- 최적의 모델이 얻어질 때까지 반복합니다.

- 변수 선택 기준(Selection Criteria):

- 변수 선택을 수행할 때 사용되는 기준으로는 AIC(Akaike Information Criterion), BIC(Bayesian Information Criterion), 잔차 제곱합(RSS, Residual Sum of Squares) 등이 있습니다.

- 이러한 기준은 모델의 복잡성과 적합도를 고려하여 변수를 선택합니다.

- 교차 검증(Cross-Validation):

- 모델의 일반화 성능을 평가하기 위해 교차 검증을 사용하여 변수 선택을 수행할 수 있습니다.

- 교차 검증을 통해 각 변수의 중요성을 평가하고 변수를 선택할 수 있습니다.

- Bootstrap Sampling:

- 부트스트랩 샘플링은 재표본추출 방법 중 하나로, 주어진 데이터 집합에서 복원 추출을 통해 샘플을 반복적으로 추출하는 과정입니다.

- 이 방법을 사용하면 주어진 데이터 집합에서 표본 통계량의 분포를 추정하고, 신뢰 구간을 계산할 수 있습니다.

- 부트스트랩은 통계 모델링 및 예측에서 모델의 불확실성을 추정하는 데 사용됩니다.

- Poisson Distribution:

- 포아송 분포는 일정 시간 또는 공간에서 발생하는 이벤트의 횟수를 모델링하는 데 사용됩니다.

- 포아송 분포는 이산 확률 분포로, 주어진 시간 동안 또는 고정된 공간에서 발생하는 이벤트의 평균 발생 횟수를 나타내는 파라미터 에 의해 정의됩니다.

- 주로 희귀한 사건이 발생하는 경우에 사용됩니다.

- Non-/Hierarchical Clustering:

- 클러스터링은 비슷한 개체를 그룹화하는 기술로, 비슷한 개체 간의 유사성을 기반으로 합니다.

- 비계층적 클러스터링은 사전에 클러스터의 개수를 지정하지 않고 데이터를 클러스터링하는 방법입니다. K-means 클러스터링은 대표적인 비계층적 클러스터링 기법입니다.

- 계층적 클러스터링은 데이터를 트리 구조로 클러스터링하는 방법입니다. 이러한 방법은 계층적 구조를 사용하여 서로 다른 수준의 유사성을 표현할 수 있습니다.

-

- 비계층적 클러스터링(Non-hierarchical Clustering):

- 비계층적 클러스터링은 사전에 지정된 클러스터 수에 따라 데이터를 그룹화합니다.

- 주로 K-means 클러스터링 알고리즘이 사용됩니다.

- K-means 알고리즘은 랜덤한 중심점에서 시작하여 각 데이터 포인트를 가장 가까운 중심점에 할당하고, 클러스터의 중심을 다시 계산하여 반복하는 방식으로 클러스터를 구성합니다.

- 계층적 클러스터링(Hierarchical Clustering):

- 계층적 클러스터링은 데이터를 계층적 트리 형태로 구성합니다.

- 계층적 클러스터링에는 병합 군집화(AGNES, Agglomerative Nesting)와 분할 군집화(DIANA, Divisive Analysis) 두 가지 주요 접근 방식이 있습니다.

- 병합 군집화는 각 데이터 포인트를 개별적인 클러스터로 시작하여 유사한 클러스터를 합치는 방식으로 클러스터를 형성합니다.

- 분할 군집화는 모든 데이터 포인트가 하나의 클러스터에 속한 상태에서 시작하여 서로 다른 클러스터로 분할하는 방식으로 클러스터를 형성합니다.

- 비계층적 클러스터링(Non-hierarchical Clustering):

- Conditional Probability:

- 조건부 확률은 한 사건이 다른 사건이 발생했을 때의 확률을 나타냅니다.

- 는 사건 가 발생했을 때 사건 가 발생할 확률을 나타냅니다.

- 조건부 확률은 베이즈 정리와 같은 통계적 추론 및 예측에 널리 사용됩니다.

논술형 : 1번

1.로지스틱 회귀 문제

1-1) (x1,x2,x3) = ( ~,~,~) 일 때, Y는 0 인가 1인가?

로지스틱 회귀 모델의 결과로 Y의 예측값이 0.5 이상이면 1로, 그렇지 않으면 0으로 분류합니다.

1-2) x1,x2,x3 각 변수가 유의한지검정하라 ( 가설, 검정통계량, 분포 설명)

로지스틱 회귀에서 개별 변수의 유의성을 검정할 때는 일반적으로 Wald 검정 또는 likelihood ratio 검정을 사용합니다. 이 중 Wald 검정은 각 변수의 계수를 표준 오차로 나눈 값이 Z 분포를 따르는 검정 통계량으로 계산됩니다. 가설은 각 변수의 계수가 0인지 아닌지를 검정하며, 유의수준에 따라 기각 여부를 결정합니다.

1-3)x3의 계수에 대한 해석. odds ratio를 이용하여 해석하라.

Odds ratio(오즈 비율)는 두 사건의 발생 가능성을 비교하는 데 사용되는 통계적 측도입니다. 주로 이항 분포에서 확률을 비교할 때 사용됩니다.

로지스틱 회귀 분석에서는 각 독립 변수의 계수를 통해 Odds ratio를 계산할 수 있습니다. 이는 해당 독립 변수가 종속 변수에 미치는 영향을 해석하는 데 사용됩니다. Odds ratio는 발생 가능성의 비율로 해석되며, 1보다 크면 해당 독립 변수가 종속 변수에 긍정적인 영향을 미치는 것을 의미하고, 1보다 작으면 부정적인 영향을 미칩니다. 예를 들어, Odds ratio가 2라면 해당 독립 변수의 한 단위 증가가 종속 변수의 발생 가능성을 2배로 증가시킨다는 것을 의미합니다. 만약 Odds ratio가 0.5라면 해당 독립 변수의 한 단위 증가가 종속 변수의 발생 가능성을 0.5배로 감소시킨다는 것을 의미합니다.

1-4)위 결과를 바탕으로 전체 모형이 유의한지 검정하라.

전체 모형의 유의성은 likelihood ratio 검정 또는 Wald 검정을 사용하여 검정할 수 있습니다. 유의확률이 유의수준보다 작으면 귀무가설을 기각하고 전체 모형이 유의하다고 결론지을 수 있습니다. 유의확률이 0.7이면 귀무가설을 기각할 수 없으므로 모형은 유의하지 않습니다.

적률생성함수로 분포 증명하는거

3.검정력 문제

n=?

X ~ N(u, 16)

3-1) 표본평균의 기각역

h1 : u < 15 였던 걸로 기억.

잘 계산해서 표본 평균에 대한 식으로 바꾸는 문제.

3-2) u= 12일 때 검정함수? 검정력? 구하기.

#주어진 표 : z값 주는 테이블

4.일반화에 대한 문제.

과대적합과 과소적합에 대해서 설명하고 해결방안을 서술하라.

과대적합(Overfitting)은 모델이 학습 데이터에 너무 맞춰져서 새로운 데이터에 대한 일반화 성능이 떨어지는 현상을 의미합니다. 반면, 과소적합(Underfitting)은 모델이 너무 단순하여 학습 데이터의 패턴을 잡아내지 못하고 성능이 떨어지는 현상을 말합니다.

과대적합의 경우, 모델이 학습 데이터에 너무 맞춰져서 학습 데이터의 잡음까지 학습하여 발생할 수 있습니다. 이는 모델이 학습 데이터에만 잘 동작하고 실제 데이터에서는 성능이 떨어지는 결과를 초래할 수 있습니다. 반면, 과소적합은 모델이 너무 단순하거나 학습 데이터가 너무 적을 때 발생할 수 있습니다. 이 경우 모델이 데이터의 복잡한 패턴을 잡아내지 못해 성능이 제대로 나오지 않습니다.

과대적합과 과소적합을 해결하기 위해서는 다음과 같은 방법들을 고려할 수 있습니다:

- 과대적합 해결 방안:

- 규제(Regularization): 모델의 복잡성을 줄이기 위해 가중치를 제한합니다. 대표적인 규제 방법으로는 L1 규제(Lasso)나 L2 규제(Ridge)가 있습니다.

- 교차 검증(Cross-validation): 모델의 일반화 성능을 미리 평가하여 최적의 모델을 선택합니다.

- 데이터 확장(Data Augmentation): 학습 데이터를 인위적으로 확장하여 다양한 패턴을 학습하도록 합니다.

- Feature 선택: 불필요한 특성을 제거하거나 유용한 특성을 선택하여 모델의 복잡성을 줄입니다.

- 과소적합 해결 방안:

- 모델의 복잡성 증가: 모델의 복잡성을 늘려서 학습 데이터의 패턴을 더 잘 잡아내도록 합니다. 이를 위해 모델의 층을 더 깊게 하거나, 더 많은 파라미터를 사용할 수 있습니다.

- 더 많은 학습 데이터 수집: 학습 데이터의 다양성을 확보하여 모델이 더 잘 학습하도록 합니다.

- 특성 공학(Feature Engineering): 모델이 학습하기 쉬운 특성을 만들어내는 것으로, 도메인 지식을 활용하여 새로운 특성을 생성하거나 기존 특성을 변형합니다.

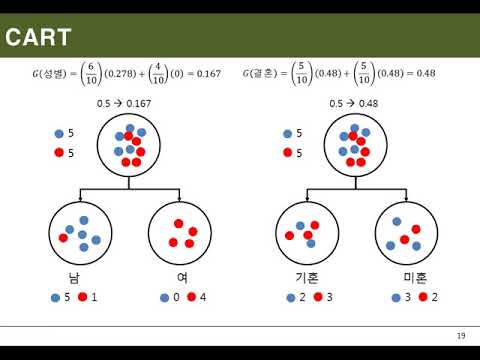

5.의사결정나무에서 Cart 기법의 분류 방식으로 옳은것은?

Cart 기법을 사용한 의사결정나무의 분류 방식은 각 노드에서 지니 불순도(Gini impurity)를 기준으로 최적의 분할을 결정하는 것입니다. A분할이 좌측으로 좀 더 치우쳤다는 것은 해당 분할로 나뉜 하위 그룹 중에서 한 클래스가 다른 클래스에 비해 더 많은 비율을 차지한다는 것을 의미합니다.

- 분할 기준 설정: CART 알고리즘은 각 노드에서 최적의 분할 기준을 찾기 위해 지니 불순도(Gini impurity)를 사용합니다. 지니 불순도는 해당 노드의 클래스 분포에 대한 불순도를 측정하는 지표로, 가능한 각 분할에 대해 지니 불순도를 계산하고 가장 낮은 값을 가진 분할을 선택합니다.

- 이진 분할: CART는 이진 트리를 구성하는 방식으로, 각 노드에서는 두 개의 자식 노드로만 분할됩니다. 각 분할은 해당 특징의 값이 기준값보다 큰지/작은지를 기준으로 이루어집니다.

- 재귀적 분할: CART는 재귀적으로 분할을 수행하여 트리를 구축합니다. 각 분할에서는 해당 노드에 대해 최적의 분할 기준을 찾고, 이를 기준으로 자식 노드를 생성합니다. 이 과정은 분할을 중지할 조건이 충족될 때까지 반복됩니다.

- 가지치기(Pruning): CART는 가지치기를 통해 트리의 크기를 조절하여 오버피팅(과대적합)을 방지합니다. 가지치기는 트리를 미리 성장시킨 후에 필요 없는 가지를 제거하는 과정으로, 검증 데이터를 사용하여 모델의 성능을 평가하고 최적의 트리 크기를 결정합니다.

6번.독립에 대한 집합연산

서로 독립인 사건 A, B

2p(A n B) = p(A n B^c)

p(A^c n B^c ) = 1/15

이 때, p (A u B) =?

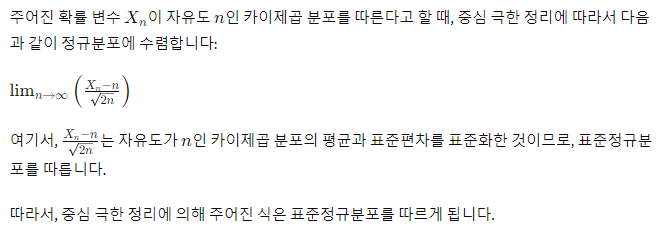

7.X_n ~ 카이제곱(n) 을 따를 때,

lim(n->무한)[ ( X_n - n ) / sqrt(2n) ] 은 어떤 분포를 따르는지?

8. 세타의 최대우도값 구하기

9.독립성 검정과 동질성 검정에 대해서 설명하고 차이점 설명

독립성 검정과 동질성 검정은 둘 다 범주형 데이터의 관계를 파악하기 위한 통계적 검정 방법입니다. 하지만 각각의 검정은 다른 목적과 가정을 갖고 있습니다.

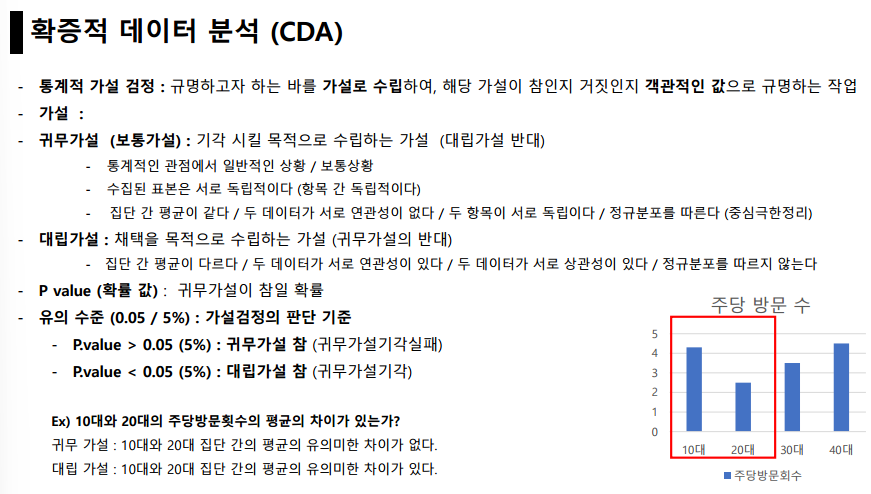

- 독립성 검정 (Independence Test):

- 독립성 검정은 두 개의 범주형 변수가 서로 독립적인지 여부를 확인하는 데 사용됩니다. 즉, 한 변수의 범주가 다른 변수의 범주에 영향을 미치는지를 검정합니다. 예를 들어, 성별과 흡연 여부가 서로 독립적인지를 검정하고자 할 때 사용될 수 있습니다.

- 대표적으로는 카이제곱 검정(Chi-square test)이 있습니다. 카이제곱 검정은 관측값과 기대값 간의 차이를 통계적으로 검정하여 두 변수 간의 독립성을 확인합니다.

- 동질성 검정 (Homogeneity Test):

- 동질성 검정은 두 개 이상의 모집단이 동질한지를 검정하는 데 사용됩니다. 즉, 두 개 이상의 그룹이 서로 유사한 특성을 가지고 있는지를 확인합니다. 예를 들어, 서로 다른 지역 간의 구매 선호도가 동질한지를 검정하고자 할 때 사용될 수 있습니다.

- 동질성 검정에는 다항 카이제곱 검정(Multinomial Chi-square test)이나 등분산 검정 등이 있습니다. 이러한 검정은 각 그룹의 분포가 동일한지를 검정하여 모집단의 동질성을 확인합니다.

차이점:

- 목적: 독립성 검정은 두 변수 간의 독립성을 확인하는 데 사용되며, 동질성 검정은 두 개 이상의 그룹이 서로 동질한지를 확인하는 데 사용됩니다.

- 검정 대상: 독립성 검정은 두 개의 범주형 변수의 관계를 확인하고, 동질성 검정은 두 개 이상의 모집단의 유사성을 확인합니다.

- 가정: 독립성 검정은 각 셀의 기대 빈도가 충분히 크다는 가정을 필요로 하지만, 동질성 검정은 추가적인 가정 없이 사용될 수 있습니다.

따라서 독립성 검정과 동질성 검정은 서로 다른 문제를 해결하기 위한 검정 방법이며, 각각의 검정은 다른 가정과 목적을 갖고 있습니다.

10.

ACF 그래프와 PACF 주어져있음.

ARMA ( , )모형을 결정하고, 모형식 쓰기.

ARMA(p, q) 모형을 결정하기 위해 ACF(자기상관 함수) 그래프와 PACF(편 자기상관 함수) 그래프를 사용합니다. ACF 그래프는 MA(q) 모형의 특성을, PACF 그래프는 AR(p) 모형의 특성을 나타냅니다. 이를 통해 모형의 차수를 결정할 수 있습니다.

먼저, ACF와 PACF를 통해 모형의 차수를 결정하겠습니다.

- ACF 그래프:

- ACF 그래프는 지속적으로 감소하거나 주기적인 패턴이 없는 경우 MA(q) 모형의 가능성이 높습니다.

- 만약 ACF 그래프가 p 시차 이상에서 갑자기 0으로 떨어지는 모습을 보인다면 AR(p) 모형의 가능성이 있습니다.

- PACF 그래프:

- PACF 그래프에서 p 시차 이상에서 갑자기 0으로 떨어지는 경우 AR(p) 모형의 가능성이 높습니다.

- 만약 PACF 그래프가 지속적으로 감소하거나 주기적인 패턴이 없는 경우 MA(q) 모형의 가능성이 있습니다.

ARIMA란? :: ARIMA 분석기법, AR, MA, ACF, PACF, 정상성이란?

앞 서, 시계열 데이터와 시계열 분석에 대한 간단한 설명과 시계열 분해법에 대해 설명했다. 2021.05.24 - [통계 지식/시계열자료 분석] - 시계열 분해란?(Time Series Decomposition) :: 시계열 분석이란? 시

leedakyeong.tistory.com

- 주어진 두 개의 변수 간의 상관관계를 분석하기 위해 어떤 통계적 방법을 사용할 것인지 설명하세요.

- 두 변수 간의 상관관계를 분석하기 위해 피어슨 상관계수(Pearson correlation coefficient)를 사용할 수 있습니다. 이는 두 변수 간의 선형적인 관계를 측정하는 통계적 방법으로, -1에서 1 사이의 값을 가지며 0은 상관관계가 없음을 의미합니다.

- 만약 두 변수 간의 비선형적인 관계를 파악하고자 한다면, 스피어만 순위 상관계수(Spearman's rank correlation coefficient)나 켄달의 타우(Kendall's tau)와 같은 비모수적인 방법을 사용할 수 있습니다.

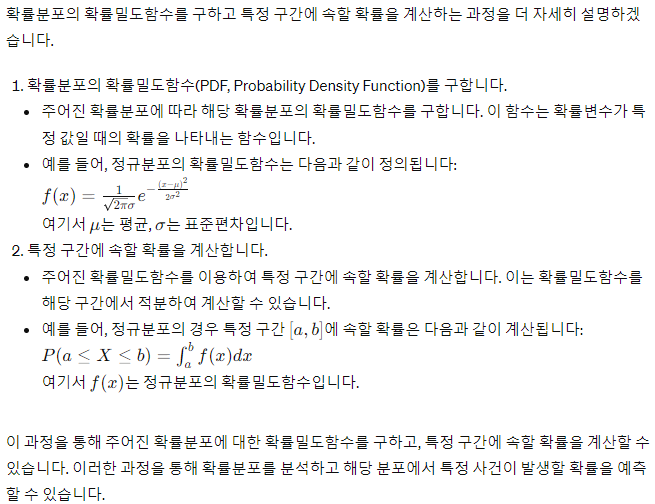

2. 주어진 확률분포의 확률밀도함수를 구하고, 특정 구간에 속할 확률을 계산하세요.

- 주어진 확률분포에 따라 해당 확률분포의 확률밀도함수를 구합니다. 이를 통해 특정 구간에 속할 확률을 계산할 수 있습니다. 예를 들어, 정규분포의 경우 평균과 표준편차를 이용하여 확률밀도함수를 구하고, 특정 구간의 확률을 적분을 통해 계산합니다.

3. 주어진 분산분석(ANOVA)의 가설 검정 결과를 해석하세요.

- 주어진 분산분석 결과에서 귀무가설과 대립가설의 유의성을 검정하고, 통계적으로 유의한 결과를 해석합니다. 예를 들어, ANOVA에서는 그룹 간의 평균 차이가 통계적으로 유의한지를 검정하며, 이를 통해 변수들 간의 관계를 해석합니다.

주성분 분석(Principal Component Analysis, PCA)은 다차원 데이터의 차원을 줄이고 데이터의 구조를 파악하는 데 사용되는 기술입니다. 이러한 핵심 특징을 추출한다는 아이디어에 기반하여 AI 학습 전에 학습 데이터를 전처리하면 효과적인 머신 러닝을 진행할 수 있다. 여기서 말하는 전처리는 데이터의 차원을 줄이는 것을 의미하는데, 이를 Principle Component Analysis(PCA), 주성분 분석이라고 한다.

PCA

1. 정의: 분산이 최대화되는 방향으로 데이터를 줄임으로써, 데이터의 주요 패턴을 캡처하며 차원을 줄이는 기법

2. 특징

a. 비지도 학습

b. 차원 축소

- 정의: 데이터의 차원을 줄이는 것.

- 목표: 데이터의 정보 손실을 최소화

- 장점: 계산 효율성 증가, 데이터 시각화, 노이즈 제거, 과적합 해결

- 단점: 정보가 손실되며 under-fitting이 발생할 수 있음

3. 과정

- 평균 계산 → 데이터 중심화 → 공분산 행렬 계산 → 고유값, 고유벡터 추출 → 주성분 선택

주성분 분석 수행 과정:

- 데이터 스케일링: 주성분 분석을 수행하기 전에 데이터를 표준화 또는 정규화하여 각 변수의 스케일을 맞춥니다.

- 공분산 행렬 계산: 주어진 데이터셋에서 변수들 간의 공분산 행렬을 계산합니다.

- 고유값 분해: 공분산 행렬을 고유값 분해하여 고유값과 고유벡터를 구합니다.

- 고유값과 고유벡터 선택: 고유값이 큰 순서대로 정렬하여 주성분을 선택합니다. 주로 설명되는 분산이 높은 주성분을 선택합니다.

- 주성분 축으로 데이터 변환: 선택한 주성분 축에 데이터를 투영하여 새로운 특징 공간으로 변환합니다.

결과 해석:

- 주성분들의 설명력 확인: 선택된 주성분들이 전체 분산에서 설명하는 비율을 확인합니다. 이를 통해 데이터의 차원 축소가 얼마나 유용한지를 평가할 수 있습니다.

- 주성분들의 의미 해석: 각 주성분은 원래 변수들의 선형 조합으로 구성되어 있습니다. 주성분의 가중치(고유벡터)를 통해 각 주성분이 어떤 변수들과 어떤 관계를 가지는지 해석합니다.

- 주성분들의 시각화: 주성분 분석 결과를 시각화하여 데이터의 패턴이나 구조를 이해할 수 있습니다. 주성분들 간의 관계를 산점도 행렬이나 바이플롯 등을 통해 확인할 수 있습니다.

- 주성분들의 활용: 주성분 분석을 통해 차원이 축소된 데이터를 활용하여 예측 모델을 구축하거나 데이터 시각화, 클러스터링 등의 작업을 수행할 수 있습니다.

이러한 과정과 해석을 통해 PCA를 이해하고 데이터의 차원 축소 및 구조 파악에 활용할 수 있습니다.

차원 축소(Dimensionality Reduction)는 데이터의 차원(특성의 수)을 줄이며 데이터의 중요한 정보를 최대한 보존하는 것을 의미한다. 일반적으로 데이터 추출 시, 노이즈 때문에 함수의 차원이 높아지고 비선형성이 커지는 경우가 많다. 이런 상황에서 차원 축소의 장점은 다음과 같다.

- 계산 효율성 증가: 데이터의 차원이 감소하면, 모델 학습과 예측에 필요한 계산량이 줄어듦

- 데이터 시각화: 차원을 축소함으로써, 데이터를 시각적으로 이해하는 것이 쉬워짐

- 노이즈 제거: 노이즈와 불필요한 정보를 제거

- 과적합 방지: 차원의 저주 문제를 해결하여 모델의 과적합을 줄임

- 차원의 저주(Curse of dimensionality)란 데이터 과학과 머신 러닝에서 데이터의 차원의 증가할수록 해당 공간의 크기가 기하급수적으로 증가하며, 데이터 분석이나 모델 학습에 어려움을 초래하는 현상을 의미한다.

반면, 차원 축소 시 데이터의 일부 정보 손실이 발생할 수 있으며, 어떤 차원을 유지하고 제거할지 결정하는 것이 복잡할 수 있다. 정보 손실로 인해 모델은 데이터의 복잡성을 충분히 표현하지 못해, 이는 under-fitting의 원인이 될 수 있다.

https://maloveforme.tistory.com/221

[딥러닝] 주성분 분석(PCA)

Principle Component Analysis(PCA) 개요 남자와 여자에 대한 다양한 특징 정보가 주어졌다고 가정해 보자. 이들을 구분하기 위한 정보는 굉장히 많을 것이다. 하지만 실질적으로 우리가 성별을 구분하기

maloveforme.tistory.com

* 주어진 분류 문제에 대해 K-최근접 이웃(K-Nearest Neighbors) 알고리즘을 적용하고 성능을 평가하세요.

- 데이터 전처리:

- 주어진 데이터셋을 훈련 데이터와 테스트 데이터로 분리합니다.

- 필요에 따라 데이터를 정규화하거나 표준화합니다.

- 모델 학습:

- 훈련 데이터를 사용하여 KNN 모델을 학습시킵니다.

- 모델 학습 과정에서는 각 데이터 포인트와 이웃 데이터 포인트 간의 거리를 계산하여 저장합니다.

- 예측:

- 테스트 데이터에 대해 각 데이터 포인트와 가장 가까운 이웃들을 찾습니다.

- 이웃들의 클래스를 확인하고, 다수결 투표를 통해 해당 데이터 포인트의 클래스를 예측합니다.

- 성능 평가:

- 예측된 클래스와 실제 클래스를 비교하여 모델의 성능을 평가합니다.

- 일반적으로 정확도(accuracy), 정밀도(precision), 재현율(recall), F1-score 등을 사용하여 성능을 평가합니다.

'𝘼𝙣𝙖𝙡𝙮𝙨𝙞𝙨 > ꜱᴛᴜ𝙳𝚈' 카테고리의 다른 글

| A/B TEST 다 뿌셔! (0) | 2023.07.15 |

|---|---|

| 의사결정을 위한 A/B 테스트 - 당근마켓 테크 블로그 리뷰(5) (0) | 2023.07.15 |

| 따뜻한 거래 후기를 위한 A/B TEST - 당근마켓 테크 블로그 리뷰(4) (0) | 2023.07.14 |

| 프로덕트 데이터 분석가의 역할 - 당근마켓 테크 블로그 리뷰(3) (0) | 2023.07.13 |

| 텍스트 속 주소 인식 - 당근마켓 테크 블로그 리뷰(2) (1) | 2023.07.13 |